我們擅長商業策略與用戶體驗的完美結合。

歡迎瀏覽我們的案例。

Meta 最新推出的視頻跟蹤工具CoTracker,發布沒多久就在 GitHub 上斬獲了 1.4k 星標。

從官方發布的幾個 DEMO 來看,效果還是很震撼的。

對這個新“玩具”,有網友評論說,它不僅能改變物體追蹤技術,也將在體育(動作)分析、野生動物追蹤,甚至電影后期領域掀起一場新的革命。

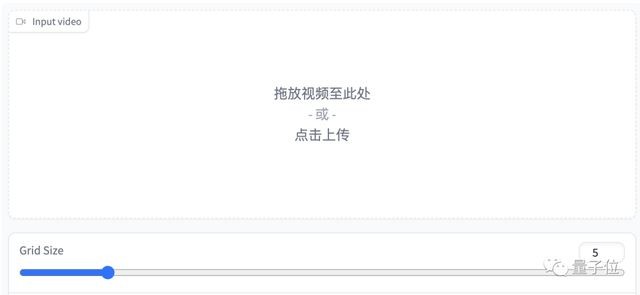

不過,在線 DEMO 是個簡易版本,還不支持自定義跟蹤位置,只能根據輸入的跟蹤數量等距分配。

但是如果自己部署、用代碼操縱的話,就可以設置任意跟蹤點了。

說到這我們正好來看一下 CoTracker 該怎么部署。

首先是 Colab 版本,我們剛剛說到的自定義跟蹤點也在 Colab 當中。

Colab 的過程不必過多介紹,進入之后運行筆記中的代碼就可以了。

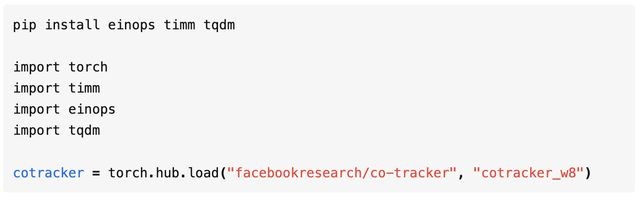

而如果想自己動手的話,最簡單的方式是從 torch.hub 中直接調用已完成預訓練的版本。

如果要對模型進行評估或訓練,那么使用 GitHub Repo 更為合適。

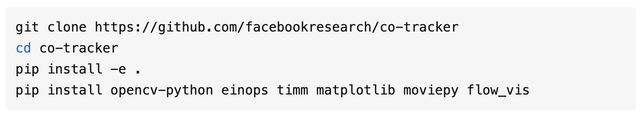

首先要安裝一下程序和相關依賴:

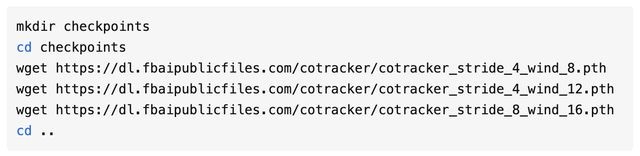

然后下載模型:

有關評估和訓練的方式,可以到 GitHub 項目頁來查看,鏈接放在了文末。

那么,CoTracker 又是怎么實現像素級追蹤的呢?

評分超過 DINOv2

雖然都是追蹤,但 CoTracker 和物體追蹤模型有很大區別。

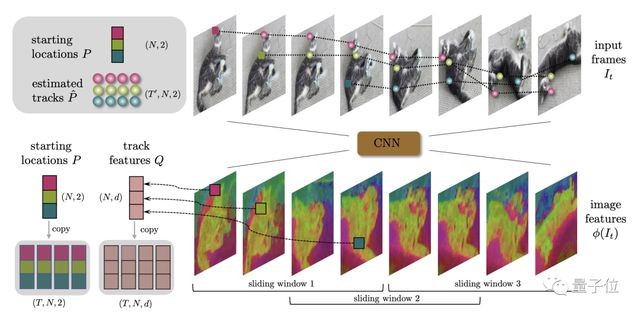

CoTracker 并沒有基于語義理解對視頻中物體進行分割的過程,而是把重點放在了像素點上。

底層方面,CoTracker 采用了 Transformer 架構。

Transformer 編碼了視頻中點的跟蹤信息,并迭代更新點的位置。

推理上,CoTracker 還采用了一種窗口機制,在時間軸上劃分出滑動窗口。

CoTracker 使用上個窗口的輸出對后面的窗口進行初始化,并在每個窗口上運行多次 Transformer 迭代。

這樣就使得 CoTracker 能夠對更長的視頻進行像素級跟蹤。

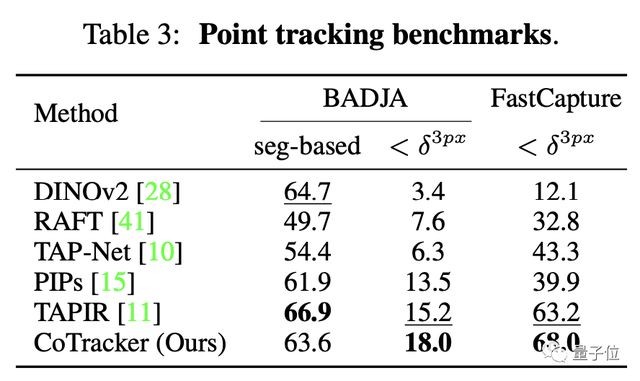

總之,經過一番訓練之后,CoTracker 取得了一份不俗的成績單。

在 FastCapture 數據集測試上,CoTracker 的成績在一眾模型中脫穎而出,其中也包括 Meta 自家的 DINOv2。

總之,喜歡的話,就趕緊體驗一下試試吧!